Amazon S3 : MAJ du management du cycle de vie des fichiers

Amazon Simple Storage Service (S3) est LE service AWS par excellence. Lancé en 2006, ce service de stockage objet peut héberger tous vos fichiers jusqu'à 5 téraoctets en assurant une disponibilité de 99,99% et une durabilité de 99,999999999% (lisez "onze-neuf"). Utilisé par des entreprises comme Netflix, Wetransfer et Dropbox, Amazon S3 permet également de stocker tout type de fichiers statiques accessibles depuis internet : le site et le blog Osones sont par exemple intégralement stockés sur Amazon S3.

Le service de stockage Amazon S3 se décline en plusieurs classes permettant la gestion du cycle de vie de vos objets : Amazon S3 RRS (Reduced Redundancy Storage) pour les données non critiques, Amazon S3 IA (Infrequent Access Storage) pour les objets peu utilisés, et Amazon Glacier pour le stockage à froid. Il est ensuite possible de pré-définir des règles qui vont s'appliquer à des buckets particuliers ou à des fichiers utilisant un certain préfixe pour automatiser le cycle de vie. Par exemple, tout fichier stocké sur Amazon S3 devra être déplacé vers Amazon IA après 30 jours.

Depuis cette semaine, la gestion des cycles de vie d'Amazon S3 s'étend pour inclure deux nouveaux cas particuliers :

- Les "Multipart Uploads" incomplets :

Pour les fichiers dont la taille dépasse les 100 MB, il est recommandé d’avoir recours au système d’upload multipart d’AWS. Ce découpage offre de nombreux avantages :

- Vous avez la possibilité de découper votre fichier en morceaux afin de paralléliser l'upload. En cas d’erreur de transfert lors d’un upload, vous n'aurez qu'à renvoyer la partie manquante.

- Vous pouvez étaler vos upload dans le temps, ce dernier n’étant pas limité entre la réception de la première et de la dernière partie - sauf demande explicite de votre part.

- Vous pouvez uploader un projet avant de l’avoir terminé : vous n’avez pas besoin de connaître le taille de l’objet avant de lancer un upload en multipart.

Depuis mars 2016, il est possible d'appliquer les règles de cycle de vie à ces fichiers fractionnés. Dès lors, vous pouvez automatiser la suppression des fichiers dans le cas d'uploads incomplets.

- Les "Delete markers" expirés :

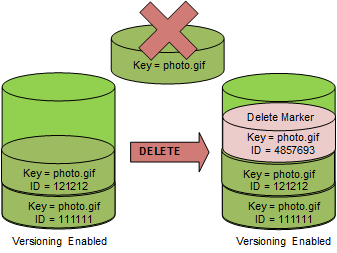

Amazon S3 propose un service de versioning qui permet de conserver différentes versions d'un même objet, et de retrouver un objet qui aurait été accidentellement supprimé. En effet lorsque le versioning est activé, un DELETE ne permet pas de supprimer définitivement un objet. Au lieu de cela, Amazon insère un "delete marker" dans le bucket, ce marker devenant la nouvelle version du fichier. Vous pourrez toujours accéder à votre objet, mais une requête depuis internet renverra une erreur 404.

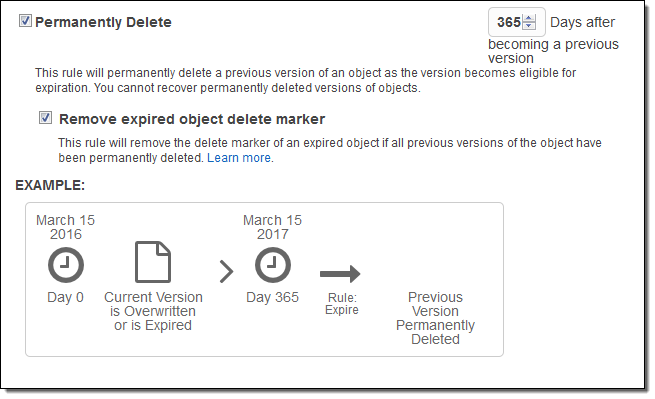

Dès lors si le versioning est activé dans vos buckets Amazon S3, toute demande de suppression d'objet après X jours se traduira par la création d'un Delete marker. Si toutes les versions précédentes de votre objet ont été supprimées, alors ces delete markers deviennent inutiles : ils expirent. Ces derniers ne sont pas facturés, mais peuvent parfois ralentir les requêtes LIST de vos buckets. C'est pourquoi AWS se propose désormais de supprimer automatiquement ces "Delete markers" expirés.

Retrouvez l'article original sur le blog AWS (en).

Nouvelles options de failover sur Amazon Aurora

Annoncé lors de l'AWS re:Invent 2014 - la keynote Annuelle d'Amazon Web Services - Amazon Aurora est un moteur de base de données relationnelle géré via le service Amazon RDS.

Compatible avec MySQL 5.6, Amazon Aurora garantit un débit jusqu'à 5 fois supérieur à celui d'une base de données MySQL standard, à matériel égal. Côté sécurité et PRA, Amazon Aurora isole vos données dans un VPC Amazon et peut chiffrer automatiquement vos données en transit.

Par ailleurs, Aurora est conçu pour offrir une disponibilité de plus de 99,99 %, en répliquant les données entre six et quinze fois entre les différentes AZ, et en les sauvegardant en continu dans Amazon S3. La restauration en cas de panne physique du système de stockage est transparente et les instances redémarrent généralement en moins d'une minute. De quoi assurer sereinement la continuité de vos applications.

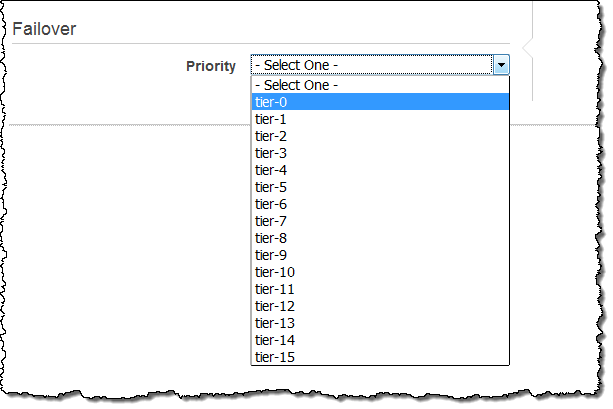

Depuis mars 2016, Amazon Aurora vous donne désormais de choisir la priorité de vos replicas. Pour cela, chacun de vos replicas est associé à une priorité allant de 0 à 15. En cas de failover, Amazon RDS va suivre votre ordre de priorité pour définir le nouveau Master. Dans les cas où deux replicas auraient le même niveau de priorité, RDS va favoriser le replica ayant la même taille que le précédent master.

Retrouvez l'article original sur le blog AWS (en).

Amazon EMR 4.4.0

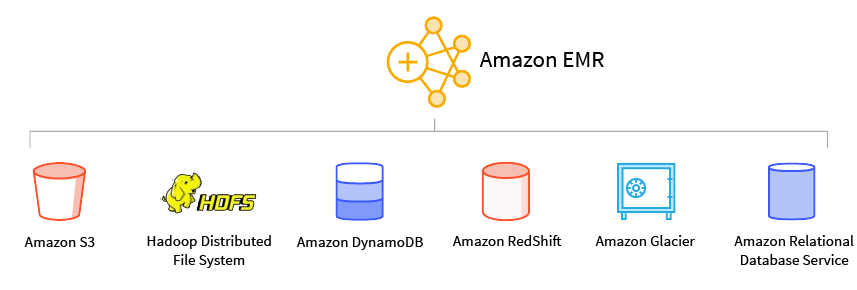

Amazon EMR (pour Elastic Map Reduce) simplifie le traitement de Big Data, en fournissant un framework Hadoop géré qui vous permet de distribuer et de traiter de manière simple, rapide et rentable, de grandes quantités de données à travers vos instances Amazon EC2. Vous pouvez également exécuter d'autres frameworks distribués courants tels que Spark et Presto dans Amazon EMR, et interagir avec les données d'autres magasins de données AWS tels qu'Amazon S3 et Amazon DynamoDB.

Depuis mars 2016, la version 4.4.0 d'Amazon EMR est disponible. Cette MAJ ajoute le support d'Apache Sqoop (1.4.6) et d'Apache HCatalog 1.0.0, une version mise à jour d'Apache Mahout (0.11.1), et des versions sandbox mises-à-jour de Presto (0.136) et d'Apache Zeppelin (0.5.6). Les réglages par défaut d'Apache Spark ont également étés mises-à-jour. Enfin, cette version supporte Java 8.

Retrouvez l'article original sur le blog AWS (en).

Rejoignez vous aussi la conversation !

Questions, remarques, suggestions... Contactez-nous directement sur Twitter sur @osones !

Pour discuter avec nous de vos projets, nous restons disponibles directement via contact@osones.com !

Rejoignez VOTRE groupe LinkedIn dès maintenant : Utilisateurs Francophones d'Amazon Web Services (AWS).

Kevin MESSY

Découvrez les derniers articles d'alter way