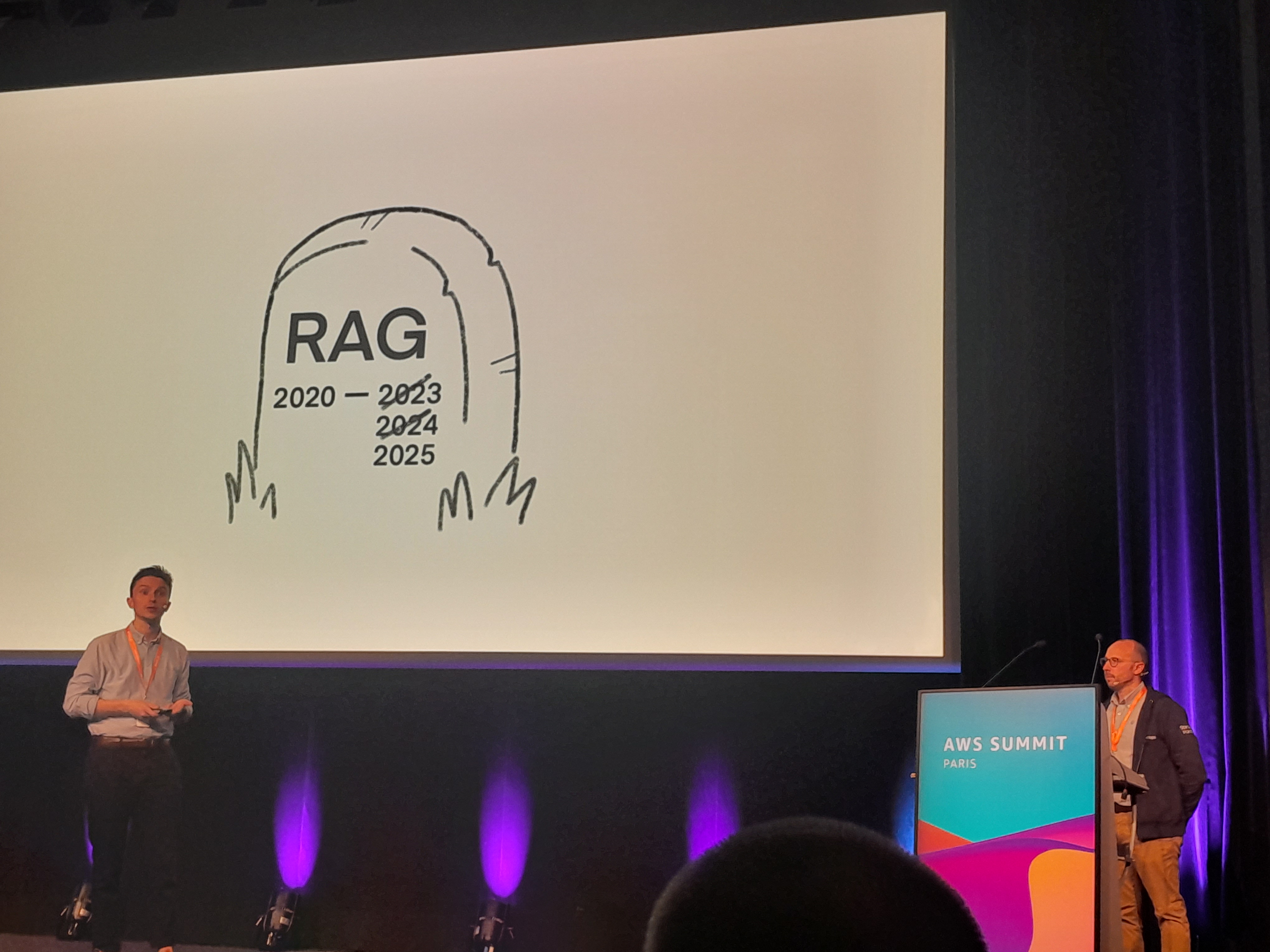

Industrialiser le RAG pour booster l’IA générative : l’approche pragmatique en 2025

Explorée en profondeur lors du AWS Summit Paris 2025, cette approche basée sur le RAG (Retrieval-Augmented Generation) s’impose comme une réponse concrète aux limites actuelles de l’IA générative en entreprise.

Un constat alarmant, une promesse ambitieuse

Le constat est clair : selon Gartner, 60 % des projets d’intelligence artificielle échouent, essentiellement par manque de données appropriées. Pour inverser cette tendance, de plus en plus d’organisations misent sur une architecture de RAG — Retrieval-Augmented Generation — industrialisée et sécurisée.

À l’ère de l’IA générative, plusieurs enjeux freinent les entreprises : comment s’assurer de la fiabilité des réponses ? Quel modèle choisir ? Comment rester conforme aux exigences de sécurité et de confidentialité ? Quel budget prévoir ? Le RAG, dans ce contexte, s’impose comme un compromis stratégique.

RAG : le bon compromis pour une IA efficace

Il existe plusieurs manières de personnaliser un modèle de langage. Le prompt engineering est rapide, mais souvent limité. À l’autre extrême, le fine-tuning est puissant mais complexe, long et coûteux.

Le RAG repose sur un principe simple : plutôt que de modifier le modèle, on lui fournit le bon contexte au moment de la requête, en allant chercher l’information dans une base documentaire interne. Pas besoin de réentraînement. Pas besoin de déplacer les données sensibles. Et surtout, des résultats pertinents dès la première itération.

Comment fonctionne un système RAG

Tout commence par la collecte des contenus internes : documents, bases de connaissances, FAQs, pages intranet, etc. Ces fichiers sont nettoyés, découpés et transformés en vecteurs numériques grâce à un modèle d’embedding. Ces vecteurs sont ensuite stockés dans une base dédiée, comme OpenSearch ou Pinecone.

Quand un utilisateur pose une question, le système recherche les passages les plus proches sémantiquement dans cette base. Ces extraits sont alors transmis comme contexte au LLM, qui génère une réponse plus précise, ancrée dans la documentation de l’entreprise.

Ce mécanisme garantit fraîcheur, pertinence et traçabilité des réponses. Il devient aussi possible d’adapter finement les résultats selon les métiers, les droits d’accès ou la langue.

Réduire les hallucinations, sécuriser les échanges, limiter les coûts

Les hallucinations sont souvent dues à un manque de contexte. En apportant les bons documents au moment de la requête, le RAG réduit fortement ce risque. Chaque réponse peut être justifiée, sourcée, et auditée si besoin.

Sur le plan de la sécurité, les données ne quittent jamais leur périmètre. Grâce à des services comme Bedrock ou SageMaker, tout reste cloisonné dans l’environnement AWS, sans exposition externe ni transfert inutile. Le respect du RGPD est ainsi facilité.

Côté budget, l’absence de fine-tuning fait une grande différence. Le coût de calcul est optimisé, et le système peut évoluer progressivement sans repasser par des phases d’entraînement lourdes à chaque changement.

Une architecture modulaire et réutilisable

L’implémentation repose sur des composants bien connus et robustes. S3 permet de stocker les documents bruts. Lambda gère les traitements automatisés. OpenSearch ou Kendra assurent l’indexation et la recherche. Bedrock ou SageMaker génèrent les réponses. Enfin, Cognito et API Gateway sécurisent les accès selon les rôles.

Cette architecture est modulaire. Elle peut être adaptée à différents secteurs, tailles d’entreprise ou contraintes réglementaires, sans compromis sur la performance ni la sécurité.

Exemple concret : un assistant IA métier chez Bureau Veritas

Chez Bureau Veritas, un assistant interne basé sur le RAG a été développé pour répondre aux questions techniques des collaborateurs. Avec plus de 90 000 documents à disposition, les experts étaient sursollicités. Il fallait automatiser sans perdre la qualité des réponses.

Le chatbot Jules a permis de répondre à cette problématique. En s’appuyant sur les briques AWS, il traite des requêtes complexes, en toute autonomie. Plus de 3 000 collaborateurs l’utilisent régulièrement, avec un taux de satisfaction supérieur à 80 %. Le temps de réponse moyen a été divisé par 10.

Ce type d’outil montre qu’une IA bien connectée à la donnée peut vraiment transformer l’expérience utilisateur interne.

Mettre à l’échelle en gardant le contrôle

Dès que l’IA commence à être utilisée au quotidien, il devient essentiel de suivre sa performance. Quelques indicateurs clés sont à surveiller : la pertinence des documents retrouvés, la qualité perçue des réponses, les temps de latence, ou encore les retours utilisateurs.

Mais il ne suffit pas de mesurer. Il faut aussi encadrer. La gestion des droits d’accès, la traçabilité des interactions, les mécanismes d’alerte en cas de comportement anormal font partie intégrante d’un RAG sérieux et responsable.

Évaluer et améliorer en continu

Un bon système RAG n’est jamais figé. Il évolue avec les usages et les données. Plusieurs leviers permettent de l’optimiser :

- des mesures automatiques (BLEU, ROUGE, F1),

- des retours utilisateurs intégrés dans la boucle,

- des tests A/B pour comparer différents modèles ou prompts,

- et surtout, un enrichissement continu de la base documentaire.

Ce dernier point est crucial : plus les documents sont clairs, bien découpés et structurés, meilleure sera la qualité des réponses générées.

Passer du test à la production

Il est tentant de rester sur une preuve de concept. Mais les outils sont là, les retours d’expérience sont solides, et les gains sont réels. Le passage en production n’a jamais été aussi accessible.

Le RAG offre un compromis unique entre rapidité de mise en œuvre, sécurité, précision et maîtrise des coûts. Il permet d’activer les gisements de connaissances internes avec une IA réellement utile.

Les données internes sont souvent le levier le plus sous-estimé des entreprises. Avec le bon outillage, elles deviennent un avantage concurrentiel tangible.

Découvrez les derniers articles d'alter way